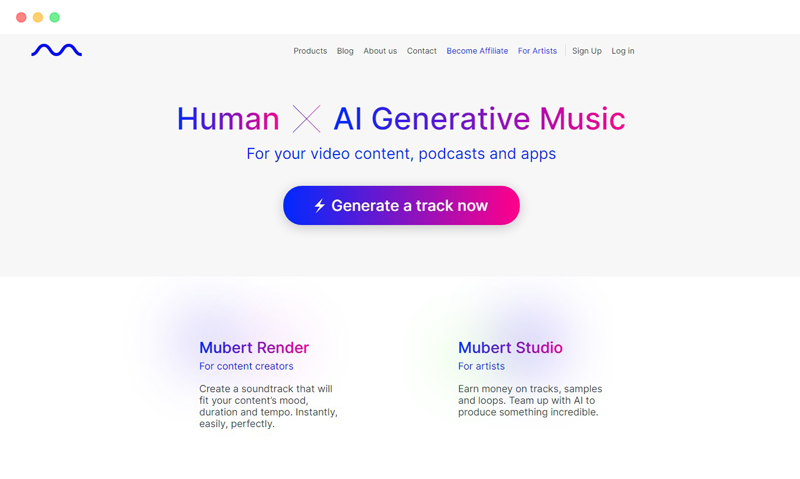

Mubert是一个免费在线AI音乐生成写歌工具,其核心产品是一个可以通过AI实时生成免版税音乐的平台。这个平台的最大亮点,是通过机器学习和音频素材的组合,创建出风格各异、情绪多样、适用于不同场景的音乐内容。Mubert并不试图替代人类音乐人,而是致力于通过技术协助创作者更高效、更合规地完成音乐创作和内容配乐。

传统音乐创作在时间、人力、版权、风格统一性等方面都存在成本高、流程长、版权风险高等难题,尤其对于需要高频使用音乐的内容创作者和商业品牌来说,获取一首合适的背景音乐既费时又费钱。Mubert正是为解决这一问题而诞生。

产品定位与价值主张

Mubert的价值主张可以从以下几个维度理解:

- 实时生成:用户无需等待,输入情绪、风格、BPM等参数,即可实时获取独一无二的音乐。

- 免版权限制:平台生成的音乐在使用授权上极具自由度,支持商业化用途,无需担心DMCA或版权警告。

- 面向多场景:涵盖视频配乐、直播背景音乐、App内嵌、游戏配乐、冥想音乐等应用场景。

- 辅助创作而非取代创作:音乐人可将自身样本上传至平台,与AI合作生成作品,保留创作主权。

- 平台即工具,也是生态:除了面向用户的前端服务,Mubert还开放API接口,赋能开发者、品牌与其他平台。

Mubert真正希望打造的是一个“人与机器共同创造”的新音乐生态,而不是一个“机器取代人”的自动音乐工厂。

用户群体与典型使用方式

根据官方资料和用户反馈,目前Mubert的主要用户群体可分为以下几类:

| 用户类型 | 主要需求 | 典型使用方式 |

|---|---|---|

| 内容创作者(如YouTuber、播客主) | 快速获取合规配乐、节省后期制作时间 | 使用 Mubert Render 工具生成匹配主题的音乐 |

| 开发者 | 为App、网站、游戏等接入动态音乐引擎 | 调用 Mubert API,按需生成符合场景的音乐 |

| 品牌和市场团队 | 制作广告或社交媒体素材时配音 | 利用平台生成的风格音乐提升视觉内容感染力 |

| 音乐人与制作人 | 将自己的音频素材用于AI生成,参与“协作创作” | 上传音频片段至 Mubert Studio,与AI共创音乐 |

| 听众用户 | 寻求适合不同情绪、场景的无干扰音乐 | 使用 Mubert Play,根据场景(学习、工作、冥想)生成音乐流 |

与大多数音乐平台不同,Mubert不是一个“播放已有歌曲”的服务,而是一个“根据指令实时生成音乐”的引擎。正因如此,它的交互模式也完全不同——用户不是在已有音乐中筛选,而是通过输入关键词或参数来“创造”。

发展历程:从实验性项目到AI音乐平台先锋

创立初衷:让音乐创作回归效率与自由

Mubert于2017年由一支技术和音乐背景混合的团队创立,早期的愿景很明确:打造一种能根据用户需求实时生成音乐的系统,摆脱传统音乐生产中“写、录、混、授权、下架”这些复杂流程的束缚。

在创始团队看来,内容创作的需求正快速增长,尤其是短视频、直播、游戏等场景,需要大量、快速、风格统一的背景音乐,而传统音乐制作流程无法满足这种高速需求。这是Mubert尝试通过AI技术打破现有音乐生产方式的关键动因。

初期产品原型是一个可以循环播放AI生成音乐的移动App。虽然功能简单,但在技术上,Mubert率先实现了“实时合成音乐”这一突破。用户选择风格或场景,音乐便自动开始生成,并可持续播放,无需人工干预。

关键发展阶段与产品演进

在成立后的几年里,Mubert经历了多个关键发展阶段,逐步从工具型产品进化为平台型服务:

| 时间 | 发展节点 | 说明 |

|---|---|---|

| 2017-2018 | 移动App测试阶段 | 发布首个AI音乐流App,面向听众提供“无限播放的AI音乐” |

| 2019 | 引入生成参数控制 | 加入节奏、风格、情绪控制选项,提升用户主动参与度 |

| 2020 | 发布Mubert API | 面向开发者和品牌开放生成服务,构建生态系统 |

| 2021 | 启动Mubert Studio | 音乐人可上传样本参与AI训练,平台构建“协作创作”机制 |

| 2022 | 推出Mubert Render | 为内容创作者提供可定制化音乐生成服务,支持视频、播客等格式 |

| 2023 | 拓展Web3应用与NFT功能 | 支持音乐NFT生成,探索链上版权管理,接入Polkadot等项目 |

| 2024 | 强化文本生成音乐功能 | 实现从自然语言生成音乐的新模式,提升定制化能力 |

每一次产品迭代都源于对用户需求的响应。从早期的纯被动听歌,到后来的内容生成与授权服务,Mubert逐步建立起面向多个使用场景的模块化产品体系。

尤其是在2021年推出Mubert Studio之后,平台不再仅是“由机器生成音乐”,而成为一个允许音乐人参与的“协同创作网络”。这是平台生态化的关键一步。

技术演进:从样本拼接到AI建模合成

Mubert的技术路径并非传统意义上的深度神经网络生成音乐(如OpenAI的Jukebox那种全模型推理),而是一种基于“智能拼接+建模合成”的混合机制。其演进过程大致如下:

- 初期阶段:依赖标注清晰的短音频样本,通过算法拼接产生流畅音乐流;

- 中期阶段:引入音乐语义理解,将BPM、情绪、和声结构等信息转化为指令引导拼接;

- 当前阶段:结合自然语言处理(NLP)与语音合成模型,实现“文本转音乐”的能力,用户只需输入“沉稳的爵士氛围”,平台即可生成与之匹配的音轨。

同时,Mubert通过用户反馈不断训练其算法模型,提升生成音乐的匹配度与艺术感。平台会记录用户跳过音乐的频率、偏好标签、播放时长等行为数据,用于算法微调。

这种“反馈驱动+人类样本+AI引导”的技术结构,使得Mubert在保留音乐个性的同时,拥有了规模化、工业化输出音乐的能力。

核心技术:支持AI音乐生成的引擎系统

Mubert作为AI音乐平台的最大亮点,在于其背后强大的音乐生成引擎。这个引擎不仅能根据用户的自然语言或参数输入生成音频,而且生成过程具备“实时性”、“风格一致性”和“版权安全性”这三大关键特点。

AI音乐生成引擎的基本架构

Mubert采用的是混合型AI生成架构,即非完全的端到端生成(如音频GAN或Transformer方式),而是结合“智能样本拼接 + 结构建模 + 音乐情感识别”的复合方案。这种方案既保障生成结果的稳定性和风格统一性,又避免了模型完全生成所带来的高计算成本和低控制精度问题。

基本流程如下:

- 输入解析 用户输入的可以是关键词(如“Lo-fi Chill”、“冥想”)、参数(如BPM、情绪、持续时长),也可以是完整的自然语言句子(如“适合工作集中注意力的氛围音乐”)。系统会对这些输入进行语义解析,并转换为结构化的音乐生成指令。

- 情感与风格匹配模型 利用自然语言处理模型(可能基于Transformer或BERT类语言模型)对输入关键词进行意图识别,将其对应到Mubert内部的音乐风格分类标签体系。

- 结构生成与样本调用 Mubert不会“从零开始”生成整首音乐,而是调用已有的样本素材池(这些样本由音乐人或平台创作上传),通过算法生成一个结构蓝图:决定开头、中段、高潮、收尾等部分应如何构建,拼接哪些节奏与旋律模板。

- 动态拼接与实时渲染 所有选中的音频片段将经过智能拼接算法进行节奏与调性调整,使得整体听起来流畅自然,避免突兀切换。这一步就是“渲染音乐”的过程。

- 输出与封装 最终音乐将被以MP3、WAV、Ogg或Web音频流的格式提供给用户,支持流媒体播放或下载。

支持“文本转音乐”的自然语言生成能力

Mubert近年来大力投入“Text-to-Music”功能的开发,使得用户只需要用日常语言描述一个场景或情绪,就能生成匹配的音乐。这一功能类似于OpenAI的“文本转图像”服务(如DALL·E),但应用在音频生成领域。

文本转音乐的关键点在于以下两方面:

- 语义-风格映射模型 系统内嵌一个“语义分类器”,可将用户输入的任意文本与Mubert已标注的音乐风格标签进行相似度计算。例如,输入“适合城市深夜街道开车时听的节奏”,模型会自动匹配到如“Chillhop”、“Midnight Electronica”、“Urban Lo-fi”等风格。

- 动态反馈调优 如果用户对生成结果不满意,可以点击“Regenerate”重新生成,系统会结合前一次反馈自动优化风格匹配参数,从而生成更贴合的内容。

这种文本转音乐的能力极大降低了音乐定制的门槛,对非专业用户尤其友好。

多模式音乐生成支持

为适应不同内容创作场景,Mubert提供了多种音乐生成模式,每种模式的底层结构略有不同,但都基于同一生成引擎衍生而来:

| 生成模式 | 功能描述 | 适用场景 |

|---|---|---|

| Track模式 | 生成一段完整结构的音乐片段(1-10分钟) | 视频配乐、播客背景 |

| Loop模式 | 生成无缝循环段落,长度短但可反复播放 | 游戏、网页背景音乐 |

| Jingle模式 | 生成极短的提示音、片头音效等 | 品牌标识、播客开头 |

| Mix模式 | 动态混音多个风格片段,制造听觉变化 | 长时间播放,如直播或展厅背景 |

这类划分不仅让内容创作者可以按需选择,还为Mubert在多样化商业场景中提供了高度适配性。

实时生成与动态播放技术

Mubert的技术还支持“实时生成”,即不预先渲染,而是在用户开始播放的那一刻,系统才根据输入生成音乐。此类机制背后的技术支撑是基于高效缓存处理与前后台流合成能力。

技术亮点包括:

- 边播放边生成(Streaming render) 在播放前只生成前30-60秒片段,随后根据播放进度继续生成内容,减少等待时间和服务器压力;

- 参数自适应机制 用户可实时调整BPM、风格等参数,音乐内容将动态过渡而非突然切换,提升体验自然度;

- Web音频兼容性 支持直接嵌入到网页、移动App、桌面应用中,开发者可调用API实时输出音轨。

这种“实时生成”不仅提升了交互性,还解决了用户对“固定音乐库审美疲劳”的问题,让每次播放都成为一种个性体验。

主要产品与功能:模块化服务满足不同用户需求

Mubert并不是一个单一产品,而是一个由多个功能模块组成的AI音乐平台。这些模块围绕不同使用需求进行设计:内容创作、开发接入、音乐协作、音频消费等,并通过Mubert的核心生成引擎提供底层能力支持。

从普通用户到企业客户,再到音乐制作人,Mubert为每类人群都提供了专门的服务接口和操作方式,形成了清晰、可组合的产品矩阵。

Mubert Render:为内容创作者打造的定制化配乐工具

Mubert Render 是目前平台最受欢迎的前端工具之一,面向视频创作者、播客主、自媒体运营者等内容从业者,提供“按需生成、即时下载”的音乐服务。

主要特点如下:

- 自定义参数生成音乐 用户可选择音乐风格(如Lo-fi、Ambient、Hip-Hop)、节奏(BPM)、时长、情绪标签等组合指令,平台实时输出配乐。

- 支持多种输出格式 音频可导出为MP3、WAV等格式,适配Premiere、Final Cut、Audacity等主流音视频编辑软件。

- 商业使用授权清晰 无论生成音乐被用于YouTube视频、播客、课程还是广告,Mubert都会提供对应授权许可,避免版权风险。

- 免登录免费试用机制 支持不注册直接试用基础功能,降低初次使用门槛。

该工具特别适合以下用户:

| 用户角色 | 使用动机 | 使用方式 |

|---|---|---|

| YouTuber | 视频背景配乐 | 输入风格+时长,生成并导出音频 |

| 播客主播 | 节目开头/过场音乐 | 选择Loop或Jingle模式 |

| 微博/B站短视频博主 | 快速生成不同风格音乐 | 用关键词匹配“适合搞笑/悬疑/校园风”等氛围 |

| 商业课程制作人 | 提高内容专业感 | 统一风格配乐,提升品牌形象 |

Mubert Studio:音乐人与AI协作的创作平台

Mubert Studio 是面向音乐人的协作平台,其理念是“人与AI共创”,即音乐人不仅是使用者,也是数据贡献者。

主要功能:

- 上传音频样本 音乐人可上传鼓点、旋律、和弦等片段素材,作为AI训练数据,系统据此生成新曲。

- 分成机制透明 每当平台使用这些样本生成的音乐被调用或下载,原创音乐人可获得相应收益分成,平台提供收益报告。

- 风格主导权保留 音乐人可设定上传样本可生成的风格范围,保障其创作理念不被过度“泛化”。

Mubert Studio的出现解决了“AI音乐侵权”、“音乐人被边缘化”等敏感问题,提供了一个相对公平透明的合作机制。

Mubert API:为开发者和品牌打造的嵌入式音乐引擎

Mubert API 面向企业开发者、SaaS平台、App开发方和音频平台,提供标准化的REST API接口,可将Mubert的生成引擎嵌入到其他系统中,实现动态音乐播放或内容伴音生成。

API支持功能包括:

- 生成特定风格音乐(根据情绪、BPM、持续时间等参数);

- 流式音频输出(无需下载,即可在线播放);

- 关键词/情境控制生成内容(如“工作”、“健身”、“冥想”等);

- 多语言调用支持与响应快速(全球部署节点)。

适用场景举例:

| 使用场景 | 功能调用方式 | 应用说明 |

|---|---|---|

| 健身App | 读取用户运动强度,自动调整BPM | 动态生成激励性音乐 |

| 冥想平台 | 生成放松类环境音乐 | 提升冥想引导效果 |

| 游戏开发 | 根据场景变化切换背景音乐 | 保持沉浸感且节约素材成本 |

| 智能穿戴设备 | 自动播放匹配场景的AI音乐流 | 个性化声音服务新趋势 |

API按调用量收费,适合需要高并发音乐生成的产品集成需求。

Mubert Play:面向听众的个性化AI音乐流服务

虽然Mubert起初并不以C端为重点,但Mubert Play仍受到大量音乐爱好者欢迎。它提供一种类似“Spotify+AI”的体验,用户无需选择歌曲,而是选择“使用场景”,AI自动生成一个连续不断、无重复的音乐流。

核心功能:

- 按场景生成音乐流 如“清晨唤醒”、“工作专注”、“城市夜跑”、“冥想减压”等,系统将持续生成匹配音乐。

- 无广告、无中断 无需手动操作,保持自然流畅的听觉体验。

- 无需登录也可使用基础功能 适合临时办公、深夜作业等临时听音需求。

Mubert Play实质上是平台技术能力的展示窗口,也为普通用户提供了一个无版权限制的“背景声音生成器”。

Mubert for Streamers:直播平台配乐的专属方案

Mubert为Twitch、斗鱼、Bilibili等直播平台的主播提供了定制服务——Mubert for Streamers,帮助解决直播过程中音乐版权与配乐切换的难题。

产品使用体验:高效、可控与用户友好兼备

Mubert的技术能力虽然高度复杂,但其面向用户的产品体验却被设计得尽量简单直接。无论是内容创作者使用Mubert Render,还是开发者调用API,亦或是普通听众使用Mubert Play,整体流程都强调“所见即所得、所输即生成”的操作哲学。

平台的设计理念是:降低音乐创作的门槛,让每个用户都能用自己的语言或偏好生成专属音乐。这一理念在交互层面体现得非常明确。

使用流程:无需复杂学习,一次上手即会用

以最常用的Mubert Render为例,其使用流程仅包含3步:

- 输入关键词或选择参数 用户在界面选择音乐风格(如Ambient、Lo-fi、Techno等),或输入文本描述(如“适合清晨冥想的安静音乐”)。

- 设定播放参数 可设定持续时间(最长可达25分钟)、节奏快慢(BPM)、音量动态等选项。部分高级选项允许用户选择Loop结构或是否包含鼓组。

- 生成与下载 点击“Generate”后,系统几秒内完成音乐渲染。用户可在线试听,满意后下载音频文件,附带标准授权文件。

整个过程无需专业音乐知识,适合零经验用户。平台界面也尽可能使用图标、预设标签降低理解成本。

对于Mubert Play听众类产品,体验更进一步简化:只需选择场景即可立即收听,无需注册或填写信息。

参数调节系统:精准控制音乐风格与节奏

Mubert允许用户从多个维度控制音乐生成参数,以实现精细化定制。常见控制项包括:

| 参数名称 | 控制作用 | 可选示例 |

|---|---|---|

| 风格(Style) | 决定整体音乐类型 | Ambient、Trap、Cinematic、Jazz |

| 情绪(Mood) | 调整音乐的情绪色彩 | Happy、Dark、Peaceful、Energetic |

| BPM(节奏速度) | 控制音乐的快慢 | 60–180区间 |

| 持续时间 | 控制音乐的总长度 | 15秒、1分钟、5分钟、10分钟等 |

| 结构模式 | 控制是否有段落变化 | Track(完整结构)、Loop(无变化) |

BPM调节与情绪标签可以组合使用,例如“快节奏 + 放松氛围”可生成现代Lo-fi风格;“慢节奏 + 神秘氛围”可生成电子冥想类音乐。

用户调节这些参数后,系统的AI引擎将在样本库中自动筛选出匹配片段,再根据蓝图生成完整音轨。这一“组合式生成”机制,比随机或固定模板更灵活,也更可控。

音乐质量与多样性:实用性强、可听性好

虽然AI生成的音乐相比人类作曲在复杂性上仍有差距,但Mubert所输出的音轨在以下几个方面已达到实用标准:

- 听感连贯,不会突兀跳段:无论Track还是Loop模式,都保证音乐在结构上的自然性;

- 风格贴合输入指令:若输入“Future Bass、激励型”,系统输出的确会有节拍明显、情绪昂扬的特征;

- 情绪表达准确:如“Calm”、“Suspense”等情绪标签所生成的音乐在情感传达上表现明显;

- 无低质音色或AI崩溃感:相比一些端到端AI生成音乐中出现的“失控噪音”,Mubert输出极少出现技术故障音轨。

平台生成的音乐可直接用于商业内容制作,不需要额外混音或音质处理,节省了创作者大量后期制作时间。

与主流创作平台的兼容性良好

Mubert输出的音频文件支持以下格式:

- MP3(压缩格式,适用于网络使用);

- WAV(高质量格式,适合后期处理);

- OGG(适合网页嵌入);

- M3U音频流(适用于播放器或网页App);

这些格式可直接导入Premiere Pro、Final Cut Pro、Adobe Audition、Logic Pro X、GarageBand等主流剪辑工具中,用户无需进行格式转换,提升效率。

此外,Mubert还支持通过Web插件或API方式嵌入到其他平台中,例如:

- 可在OBS中作为直播配乐来源;

- 可在Notion、Trello等办公工具中内嵌背景音乐;

- 可通过Zapier、IFTTT设置自动生成配乐任务流。

这种开放生态,使得Mubert不仅是音乐生成工具,更是创作流程的一环,具备良好的“集成适配力”。

用户反馈与交互优化:强调即时性与反复试验

用户在使用Mubert的过程中,若对生成结果不满意,可直接点击“Regenerate”重新生成。系统会根据同一组参数微调生成内容,尝试不同片段组合。

这一机制鼓励用户“尝试式生成”,在不增加成本的前提下找出最理想的音轨。

同时平台也记录下用户常用标签与偏好设定,在下次生成时提供预设建议,提升生成效率与个性匹配度。